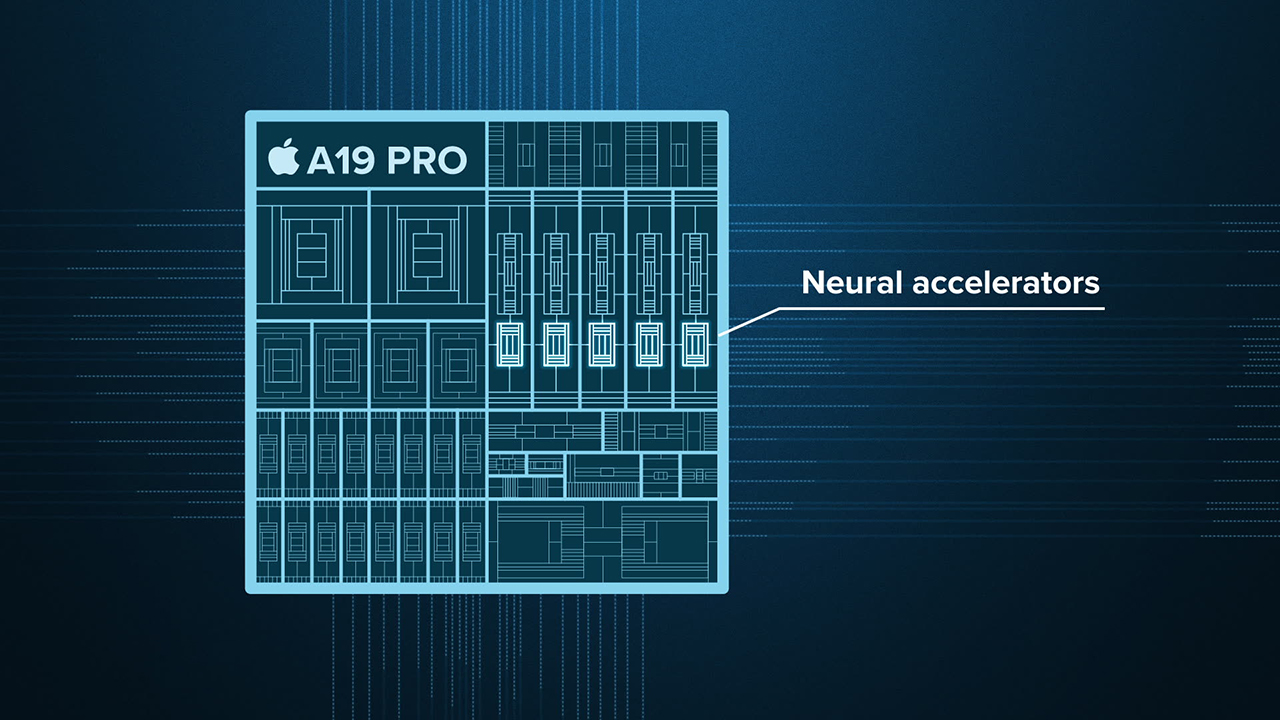

Neural Accelerators là gì? Nguyên lý hoạt động, lợi ích, sản phẩm Apple hỗ trợ Neural Accelerators

Bạn có bao giờ tự hỏi làm sao mà chiếc điện thoại chỉ nhỏ gọn lại có thể thực hiện việc nhận diện khuôn mặt, tạo ảnh AI hay xử lý lời nói cực nhanh? Câu trả lời nằm ở bộ phận mới tên là Neural Accelerator. Trong bài viết này, hãy cùng mình tìm hiểu Neural Accelerators là gì nhé.

1. Neural Accelerators là gì?

Neural Accelerators là những bộ vi xử lý chuyên biệt được thiết kế để thực thi nhanh và hiệu quả các mô hình mạng thần kinh nhân tạo – từ nhận diện hình ảnh, xử lý giọng nói, đến các tác vụ phân loại và dự đoán. Khác với CPU/GPU truyền thống, các bộ tăng tốc này tập trung vào các phép tính ma trận, tensor và nhân-cộng lớn song song, đồng thời tối ưu hoá về độ trễ và mức tiêu thụ điện năng.

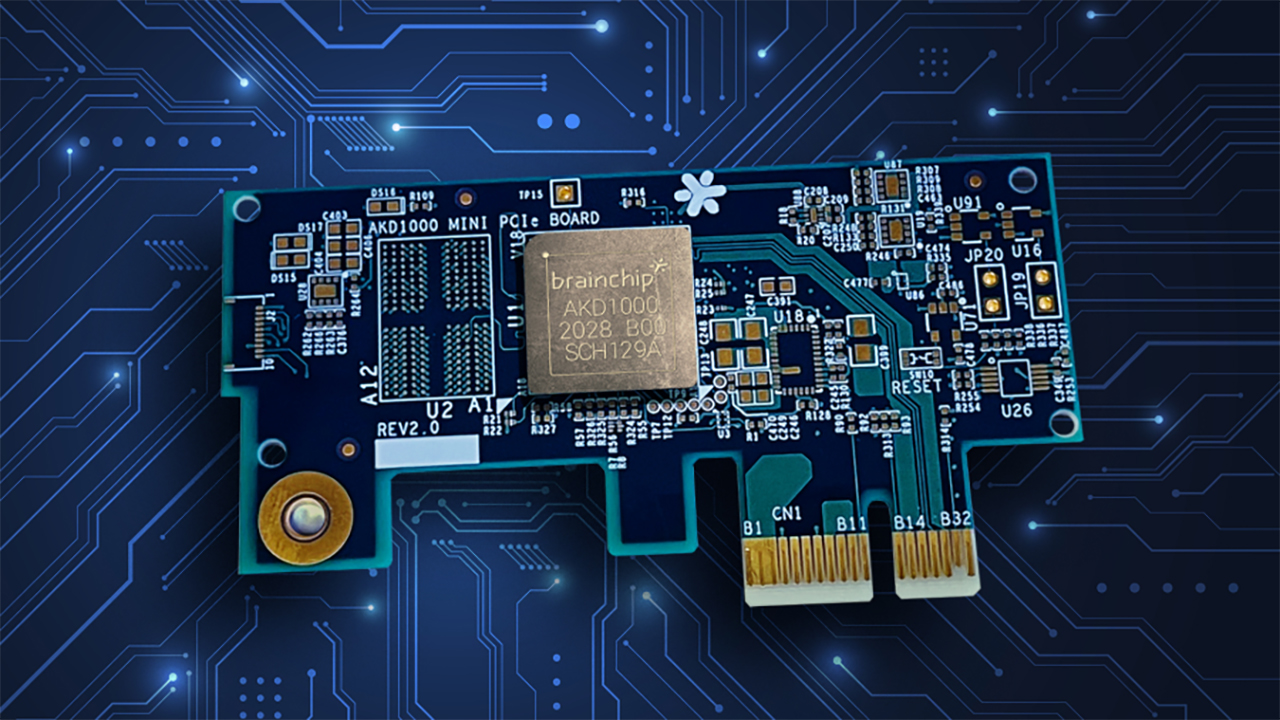

Việc sử dụng Neural Accelerators đang mở rộng rất nhanh: chúng được tích hợp từ các thiết bị biên như điện thoại thông minh, camera thông minh, xe tự lái cho tới các trung tâm dữ liệu chuyên xử lý AI quy mô lớn. Việc chuyển từ xử lý đám mây sang xử lý tại thiết bị nhờ các bộ tăng tốc giúp giảm độ trễ, tăng tính riêng tư và tiết kiệm năng lượng.

2. Nguyên lý hoạt động của Neural Accelerators

Khi một mô hình neural network (cho inference hoặc training) được đưa lên accelerator, bước đầu là tải trọng số và kích hoạt đầu vào vào bộ nhớ chuyên dụng hoặc bộ nhớ trên chip.

Sau đó, accelerator sử dụng mảng (array) xử lý song song – thường là systolic array hoặc mạng xử lý vector/tensor – để thực hiện hàng loạt phép toán như: W * x + b, rồi tiếp chung với hàm kích hoạt hoặc hàm tiếp theo trong mạng.

Trong quá trình đó, để tiết kiệm năng lượng và tăng hiệu suất, accelerator sẽ khai thác các đặc điểm như sparsity (nhiều giá trị bằng 0 trong kích hoạt hoặc trọng số) để bỏ qua việc tính toán không cần thiết, cũng như tận dụng khả năng tái sử dụng dữ liệu giữa các phép tính, giảm việc đọc/ghi bộ nhớ ngoài.

Kết quả là: Nhiều phép tính được thực hiện song song, dữ liệu được giữ gần phần xử lý. Do đó độ trễ thấp hơn, hiệu suất cao hơn và mức tiêu thụ điện năng thấp hơn nhiều so với việc chạy trên CPU thông thường.

3. Lợi ích của Neural Accelerators

Tiết kiệm năng lượng

Các neural accelerator được thiết kế chuyên biệt cho các phép tính mạng thần kinh nên hiệu quả năng lượng cao hơn nhiều so với CPU/GPU truyền thống. Điều này rất quan trọng đặc biệt ở các thiết bị edge (thiết bị biên) như điện thoại, camera, IoT – nơi mà tiêu thụ điện và tản nhiệt là hạn chế.

Độ trễ thấp & tốc độ cao

Neural accelerators cho phép xử lý hàng loạt phép toán song song, tối ưu cho ma trận/tensor, nhờ đó đáp ứng nhanh hơn, độ trễ thấp hơn. Ví dụ, ở các ứng dụng thời gian thực như xe tự lái, camera thông minh, hoặc xử lý lời nói – việc phản hồi nhanh là rất quan trọng.

Ngoài ra, chuyên dành cho mạng neural nên chúng có thể xử lý khối lượng lớn phép toán lớn hơn so với CPU thông thường.

Tối ưu cho inference và edge computing

Các neural accelerator thường được dùng cho inference (dự đoán/thực thi mạng thần kinh) hơn là training, đặc biệt “tại thiết bị” (on-device) hoặc biên (edge) – nhờ đó giảm nhu cầu gửi dữ liệu lên đám mây, giảm độ trễ và tăng bảo mật riêng tư.

Điều này giúp các thiết bị thông minh (smartphone, camera, xe hơi) thực hiện các tác vụ như nhận diện ảnh, giọng nói, hay phân loại dữ liệu cảm biến,… ngay tại thiết bị.

Khả năng mở rộng & hỗ trợ kiến trúc chuyên biệt

Neural accelerators thường hỗ trợ kiến trúc song song lớn, khả năng mở rộng và kiến trúc dữ liệu chuyên biệt (data-flow, bộ nhớ băng thông cao).

Điều này giúp các ứng dụng AI lớn (ví dụ trung tâm dữ liệu) hoặc ứng dụng thời gian thực ở biên đều có thể được hỗ trợ hiệu quả hơn nếu thiết bị có accelerator thích hợp.

4. Sản phẩm Apple hỗ trợ Neural Accelerators

Các sản phẩm hỗ trợ Neural Accelerators gồm: iPhone 17 Pro, iPhone 17 Pro Max, iPad Pro M5, MacBook Pro M5.

Neural Accelerators chính là bộ não AI giúp các thiết bị thông minh và nhanh nhạy hơn bao giờ hết.